El efecto bola de nieve de la ciberseguridad

Con las comunidades de desarrollo y los equipos de productos, hay muchas cosas que se han unido: todo, desde nuevos desarrolladores, la introducción de código abierto, nuevas APIs, técnicas de desarrollo ágiles, la nube, DevOps, DevSecOps, etc. Eventualmente, si no maneja esto, lo alcanzará y llegará a un punto sin retorno. Ya sea que sea una empresa pequeña, una empresa mediana o una gran empresa, si ignora y no aborda estos problemas, terminaremos en una brecha de seguridad (golpeada por la bola de nieve). Es posible que muchas personas no se den cuenta de que el ciberdelito es más rentable que el tráfico mundial de drogas. Ahora, considere ese hecho, y las API son importantes porque los delincuentes van a ir a donde están los datos.

La seguridad de la API todavía es relativamente nueva. El Top 10 de seguridad de API de OWASP se lanzó a finales del 2019. Por lo tanto, solo llevamos poco más de dos años para tener estas vulnerabilidades de seguridad de API bien definidas como una industria que los profesionales del software ahora pueden comenzar a abordar.

Entonces, la pregunta sigue siendo: ¿Cómo se puede evitar un incendio en un contenedor de seguridad de API?

Antes de hablar sobre lo que funciona, abordemos algunas fallas que hemos visto en el camino.

El enfoque Whack-a-Mole – Encontramos un problema; arreglamos un problema. Si alguna vez has jugado al juego, golpea un topo, sabes que lo golpeas con un mazo y aparece otro y, con el tiempo, su velocidad y número aumentan a medida que intentas golpearlos, tratando desesperadamente de mantener el ritmo. En algún momento te das cuenta de que no hay esperanza de ganar el juego porque los topos llegarán más rápido de lo que puedas derribarlos. Lo mismo ocurre con la analogía de la bola de nieve, nunca tendrás suficientes bolas de nieve para atacar todas las amenazas. Este enfoque puede funcionar por un tiempo, pero lo alcanzará y se producirá una infracción.

Solo vamos a monitorear todo: como el niño que gritó lobo, los profesionales de la seguridad son profetas del infortunio hasta que alguien ve un lobo. Todos sabemos que los lobos existen y son peligrosos, pero hasta que atacan, la guía de los profesionales de seguridad a menudo se reduce a una hipérbole. Si bien puede monitorear todo, nunca tendrá suficientes monitores o personas para responder a los monitores y su relación señal / ruido tiende a ser muy alta. Como la fábula, el niño que gritó lobo, la gente puede dejar de creerte debido a todos los falsos positivos.

Política y estándares obligatorios: las políticas y los estándares son buenos, pero no son suficientes. Solo son efectivos cuando los empleados los comprenden y los utilizan en el proceso de desarrollo, lo que significa que no solo se integra en el proceso de desarrollo, sino que también forma parte de la canalización y el lanzamiento. Si es algo que está fuera de la norma del día a día, rápidamente se olvida. Si esto no está automatizado, fallará.

el enfoque de comando y control: el siguiente enfoque es la gestión de arriba hacia abajo, el enfoque de comando y control. «¡Haz esto porque yo te lo dije!» Puede funcionar hasta cierto punto, pero de manera realista, los líderes que insisten en que sus equipos sigan sus decisiones sin cuestionar pueden perder muchos aprendizajes y comentarios constructivos que podrían mejorar los productos. Este tipo de enfoque también puede causar un desequilibrio para los equipos de productos ágiles.

Colaboración: personas, procesos y tecnología

La seguridad de la API es un acto de equilibrio. Hay un aspecto de personas, un aspecto de procesos y un aspecto de tecnología. Si están fuera de balance, te caerás de tu taburete y los malos estarán listos para atacar. La seguridad de la API no es un problema de seguridad, es una responsabilidad comercial compartida. Las personas, los procesos y las tecnologías deben trabajar juntos para gestionar el riesgo. Esto es muy importante. Si no lo hace, desperdiciará mucho dinero. Si te enfocas en la tecnología e ignoras a las personas y los procesos, fracasarás. Si te enfocas en los procesos, ignoras a las personas y la tecnología, fracasarás. Si te concentras en dos de ellos, aún fallarás. Es el equilibrio de estas tres cosas lo que crea la base para un programa de seguridad de API exitoso para una organización de cualquier tamaño.

Para que la seguridad sea completamente exitosa a través del acto de equilibrio de personas, procesos y tecnología, debe encontrar formas de eliminar el trabajo manual siempre que sea posible y aumentar los esfuerzos manuales con un enfoque de cambio a la izquierda para automatizar todo, comenzando en el momento del diseño. Solo a través de la automatización y la habilitación de DevSecOps, el equipo puede mantener su velocidad y entregar un producto seguro y de calidad.

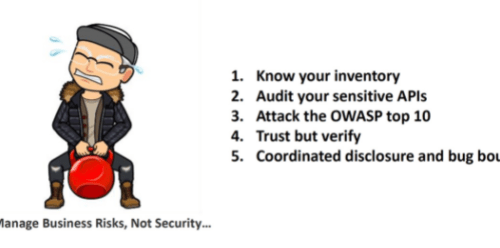

Los 5 pasos para fortalecer la postura de seguridad de las API

- Conozca su inventario: si no sabe lo que hay, las cosas pueden perderse con bastante facilidad. Los equipos pueden salir por su cuenta y volverse deshonestos y hacer cosas con grandes intenciones, pero de repente descubres que hay muchos problemas de seguridad. Así que controle absolutamente todo su inventario de API.

- Audite sus API sensibles: asegúrese de realizar una auditoría de seguridad en sus API más sensibles. De esta forma, puede encontrar y solucionar problemas de seguridad antes de que lo haga un atacante.

3.Ataque el Top 10 de seguridad de la API de OWASP: haga todo lo posible para abordar el Top 10 de seguridad de la API de OWASP. Si no está familiarizado con ellos, puede hacer clic en el siguiente para obtener más información:

A1: Control de acceso a nivel de objeto roto

A2: Autenticación rota

A3: filtrado de datos inadecuado

A4: Falta de recursos y limitación de velocidad

A5: Función faltante / control de acceso a nivel de recursos

A6: Asignación masiva

A7: Configuración incorrecta de seguridad

A8: inyección

A9: Gestión inadecuada de activos

A10: Registro y monitoreo insuficientes

4.Confíe pero verifique: debe confiar en que sus equipos harán lo correcto, pero somos humanos. La gente está bajo presión para cumplir con una fecha límite y se pueden cometer errores. A veces, las cosas simplemente suceden. Quiere asegurarse de poder verificarlo. Entonces, si algo sucede, se puede encontrar y reparar de inmediato.

5.Coordine la divulgación y la recompensa por errores: no asuma que la seguridad lo sabe todo. Invite a la gente buena para que le ayude a encontrar errores. ¡Te sorprenderá lo que puedes aprender de eso!

Más información sobre 42Crunch API Security Platform.

Queremos ser su aliado tecnológico

Permítanos conocer sus requerimientos y desarrollar una estrategia de automatización innovadora para su empresa.